Цифровые помощники с искусственным интеллектом стремительно входят в нашу жизнь. Сегодня они примеряют самые разные роли: от секретаря, помогающего вызвать врача по телефону, до внимательного собеседника, готового поддержать человека в сложной ситуации. Конек умных программ — быстрая обработка и точная оценка информации. Но чтобы стать для людей полноценной опорой, виртуальные ассистенты должны научиться еще одному — правильно воспринимать эмоции собеседника. Технологию нового уровня в этой области — ИИ-систему MASAI — представили ученые Санкт-Петербургского федерального исследовательского центра РАН (СПб ФИЦ РАН). Комплекс программ распознает семь базовых эмоций с точностью до 75–80% и превосходит аналоги по качеству работы. Подробности — в статье с комментариями руководителя проекта Алексея Анатольевича Карпова.

«Изначально вопросы проявления и распознавания эмоций пришли из области психологии, — рассказывает руководитель лаборатории речевых и многомодальных интерфейсов СПб ФИЦ РАН, профессор, доктор технических наук А.А. Карпов. — У каждого человека есть эмоциональный интеллект, один из элементов которого — эмпатия: способность сострадать, сочувствовать другим. А мы создаем компьютерную систему — эмоциональный искусственный интеллект, позволяющий машине имитировать естественный процесс человеческого общения».

Руководитель лаборатории речевых и многомодальных интерфейсов СПб ФИЦ РАН, профессор, доктор технических наук Алексей Анатольевич Карпов.

Фото: из личного архива А.А. Карпова

Родившаяся в северной столице программа MASAI (от англ. Intelligent system for Multimodal Affective States Analysis — «Интеллектуальная система для многомодального анализа аффективных состояний») сочетает в себе комплекс нейросетей. Исследование проведено при поддержке Российского научного фонда (грант №22-11-00321).

«Наша система предназначена для многомодального распознавания эмоциональных (аффективных) состояний людей. Понятие “многомодальный” означает, что выполняется анализ разнородных данных: аудиоинформации (речи и голоса), видеоинформации (мимики, поведения человека) и текстовой информации (как правило, транскрипции речи, автоматически сделанной системой), — объясняет А.А. Карпов. — С каждым видом информации работает отдельная специально обученная нейросеть. За основу алгоритмов взяты популярные модели-“трансформеры”, подобные GPT, но они модифицированы для решения поставленной задачи. Эти нейросети, в свою очередь, объединяются в большой комплекс для получения единого предсказания по данным разных модальностей. Новизна нашей работы — как раз в применении кросс-модального метода объединения информации: анализе сразу трех видов данных и, соответственно, использовании трех нейросетевых моделей. Это позволяет нам одновременно анализировать широкий спектр проявлений эмоций».

Система MASAI может распознавать семь основных человеческих эмоций: радость, грусть, удивление, спокойствие, отвращение, злость и страх. Помимо этого, она определяет сентимент — отношение говорящего: нейтральное, позитивное или негативное. Немаловажная возможность — выявление острых эмоциональных состояний (аффектов): вербальной и физической агрессии (импульсивных вспышек ярости) и депрессии.

Система MASAI может распознавать семь основных человеческих эмоций: радость, грусть, удивление, спокойствие, отвращение, злость и страх.

Фото: freepik / фотобанк Freepik

«В число аффективных состояний входят естественные эмоции, аффекты, сентимент, настроения и т.д. Они отличаются по длительности и яркости проявления. Примеры аффектов — ярость и экстаз. Они краткосрочны, но проявляются очень бурно, — перечисляет А.А. Карпов. — В то же время эмоции характерны для естественной речи. Согласно моделям эмоций Джеймса Рассела, Пола Экмана и некоторых других психологов, выделяются шесть-семь базовых эмоциональных состояний. Мы проявляем их каждый день, при этом они выражаются не очень ярко и длятся от нескольких секунд до минут. Допустим, это может быть радость от долгожданной встречи. Существуют также настроения: это слабо выраженные состояния, которые могут длиться целый день и дольше. Например, сегодня у человека удачный день и позитивный настрой, а завтра он встанет не с той ноги, и настроение у него испортится. Это также способно перерастать, допустим, в депрессию: она может проявляться неделями и месяцами, приобретая характер устойчивого заболевания. То есть здесь речь идет о негативном настроении, которое сохраняется у человека в течение достаточно продолжительного времени, но проявляется относительно слабо».

ИИ, способный распознавать эмоции, может стать ценным подспорьем при приеме звонков на телефоны доверия и в экстренные службы.

Фото: freepic.diller / фотобанк Freepik

Испытания системы показали интересную закономерность: эмоции эффективнее распознаются по аудиозаписям и видео (при этом их интенсивность лучше всего определяется по характеристикам голоса), в то время как сентимент точнее оценивается по содержанию речи. При анализе депрессии тоже стоит обращать больше внимания на мимику и речь, поскольку смысл высказываний в этом случае может оказаться недостаточно информативным (максимум — просто указать на негативный настрой).

Сделать искусственный интеллект эмоциональным — непростая, но важная задача. «Эмпатичные» цифровые помощники могут стать ценным подспорьем в разных областях. Яркие примеры — прием звонков на телефоны доверия и в экстренные службы. Только поняв, что чувствует собеседник, программа сможет оказать ему полноценную помощь. Другие области, где может пригодиться ИИ, распознающий эмоции, — медицина, психология, криминалистика, банковская сфера, когнитивные исследования.

«Наша разработка может использоваться во многих областях. Например, на ее основе можно создавать голосовые помощники, такие как “Алиса”. Сейчас над технологиями оценки эмоций для ИИ-ассистентов как раз активно работают “Яндекс” и “Сбер”. А наша команда сотрудничала с одной известной китайской корпорацией в области создания голосовых помощников для смартфона, способных определять состояние пользователя, — делится А.А. Карпов. — Наша технология может также использоваться в телефонных контакт-центрах: например, для вызова врача или экстренных служб. Мы даже проводили отдельное исследование в этой области несколько лет назад, во время пандемии коронавируса. Тогда было практически невозможно оперативно вызвать скорую помощь, до службы приходилось дозваниваться часами. Мы предложили перераспределять звонки по их приоритетности, определяя срочность обращения по эмоциям говорящего. Если человек проявляет негативные эмоции, допустим, испуг, — значит, он попал в критическую ситуацию и его нужно экстренно соединить с оператором. Если же абонент звучит нейтрально или радостно, у него есть возможность подождать».

Многомодальный анализ позволяет ИИ справляться с различными помехами. Например, если видео будет записано в полумраке, эмоции человека все еще можно будет определить по звуковой информации и содержанию речи.

Фото: KamranAydinov / фотобанк Freepik

Многомодальная оценка эмоций приближает искусственный интеллект к естественному процессу общения. Например, такая программа с большей вероятностью сможет определить, когда пользователь говорит с иронией или сарказмом. Скажем, смысл восклицания «Я очень рад!» кардинально меняется в сочетании с резкой интонацией и недовольным выражением лица. В этом случае восприятие только одного канала общения может привести к ошибочным выводам.

Кроме того, многомодальный анализ позволяет ИИ справляться с различными помехами. Если человек будет говорить на шумной улице или молчать, его эмоции все еще можно будет определить по мимике и жестам. Если пользователь отвернется от камеры или видео будет записано в полумраке, источником данных станут звуковая информация и содержание речи. Система может также проанализировать и аудиозапись без видео или текстовую расшифровку речи. Хотя, безусловно, нехватка информации по одному или нескольким каналам повлияет на итоговую точность оценки. Например, в случае анализа чисто текстовой информации качество распознавания эмоций упадет значительно.

Среди дополнительных факторов, способных повлиять на точность MASAI, — качество оборудования (например, микрофонов) и степень зашумленности. Разумеется, оценка записи, сделанной в тихом офисе, будет качественнее, чем для видео, снятого на улице или в шумной толпе.

«Нужно также понимать, что человек может испытывать одно эмоциональное состояние, а вести себя и внешне выражать по-другому. Мы можем проанализировать только то, что отражается на лице, в интонациях человека, характеристиках его речи и т.д. Залезть в душу у нас, разумеется, возможности нет», — добавляет А.А. Карпов.

Разработчики системы MASAI (слева направо): руководитель проекта Алексей Анатольевич Карпов, старшие научные сотрудники Дмитрий Александрович Рюмин и Максим Викторович Маркитантов, научный сотрудник Елена Витальевна Рюмина.

Фото: из личного архива ученых

Важное преимущество MASAI — возможность бесконтактного наблюдения.

«Для анализа эмоций можно привлекать и другие модальности: отслеживать частоту сердечных сокращений, электроэнцефалограмму, электропроводимость кожи и т.д. Но для этого нужно непосредственное взаимодействие с человеком: даже для определения пульса нужен как минимум специальный браслет. В то же время наша система абсолютно бесконтактна: мы можем определять эмоции на расстоянии, по голосу и мимике. Таким образом, при необходимости можно незаметно оценивать состояние человека, не говоря ему об этом», — подчеркивает А.А. Карпов.

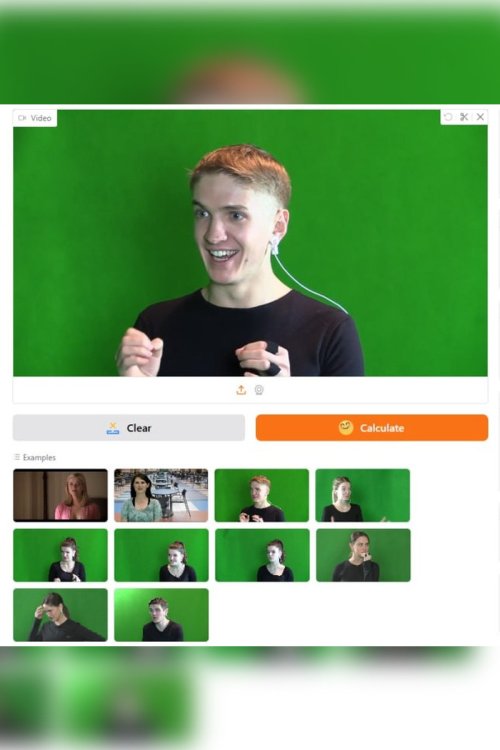

Протестировать MASAI можно уже сейчас — достаточно загрузить аудиовизуальные записи через веб-интерфейс программы на платформе HuggingFace. Система может провести анализ по заранее сделанной записи или в режиме реального времени через веб-камеру. Анализ эмоций в прямом эфире происходит с небольшой задержкой, поскольку программе необходимо изучить хотя бы несколько секунд видео и речи, чтобы сделать выводы.

«Мы представляем организацию Российской академии наук, поэтому, в первую очередь, наша специфика — выполнение научных исследований, разработка новых решений, а не непосредственная продажа изделий. При этом мы сотрудничаем с различными компаниями, желающими внедрить наши технологии в свои продукты, — поясняет А.А. Карпов. — Пока наша система представлена в виде лабораторного демонстратора. Далее, если к ней проявят интерес коммерческие партнеры, мы готовы к сотрудничеству в сфере практического применения. Но нашу технологию нельзя внедрить просто как “черный ящик”. Модели нужно адаптировать к конкретным условиям записи, языку общения, оборудованию и т.д.».

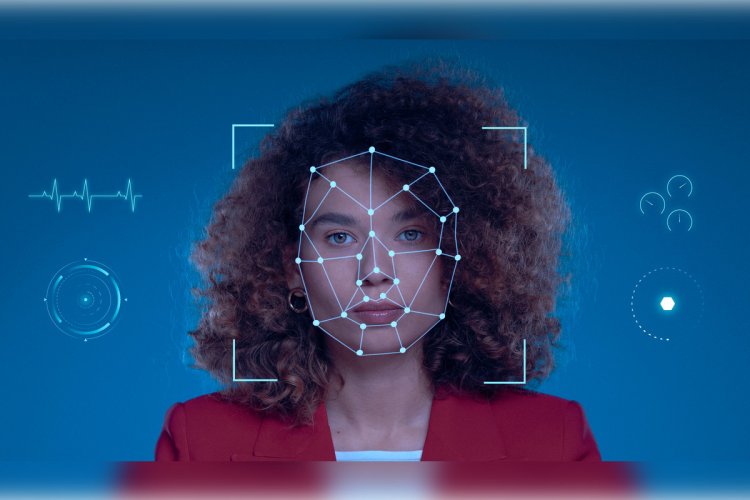

Чтобы определить эмоции по мимике, ИИ анализирует совокупность ключевых точек на лице человека, соответствующих основным чертам: рту, губам, носу, глазам, бровям и т.д.

Источник изображения: freepik / фотобанк Freepik

Как искусственный интеллект делает свои выводы? Как объясняет Алексей Анатольевич, для каждой модальности — изображения, звука, текста — существуют свои маркеры того или иного эмоционального состояния:

«В случае с мимикой система анализирует совокупность ключевых точек на лице человека, соответствующих основным чертам: рту, губам, носу, глазам, бровям и т.д. Здесь привлекаются знания из области психофизиологии и отчасти физиогномики — науки, позволяющей анализировать психологическое состояние по выражению лица. Например, удивлению соответствует поднятие бровей, радости — улыбка, грусти — опущенные уголки губ. Мы проанализировали все эти параметры и загрузили в нейронную сеть для обучения. Далее она уже самостоятельно изучила материалы и определила, какие признаки в случае с теми или иными эмоциями будут доминирующими, какие — второстепенными.

Для определения эмоций по тексту используются тональные словари, содержащие информацию об эмоциональной окраске наиболее употребимых слов.

Фото: freepik / фотобанк Freepik

Для анализа разговорной речи также используются несколько параметров: интонационный контур, частота основного тона, особенности повествования — допустим, делает ли человек паузы или говорит спонтанно, быстро. Наконец, для определения эмоций по тексту используются так называемые тональные словари. В них содержится информация о том, какой эмоциональной окраске — позитивной или негативной — соответствуют наиболее употребимые слова. Как правило, такие базы данных составляются психологами».

Для обучения и тестирования нейросетей, входящих в состав MASAI, использовались более десяти специальных исследовательских баз данных, содержащих мультиязычные видеозаписи с людьми различного пола, возраста и национальности. А аудиовизуальную базу данных по выражению агрессии ученые подготовили самостоятельно, собрав и разметив интернет-записи видеотрансляций.

Для обучения и тестирования нейросетей, входящих в состав MASAI, использовались более десяти специальных исследовательских баз данных с видеозаписями, включая российскую базу RAMAS.

Изображение предоставлено разработчиками системы

«В мире существуют различные открытые базы данных, где хранится информация о внешних проявлениях эмоций. Некоторые из них одномодальные (то есть включающие только аудиозаписи или только видео). Но мы ориентировались на многомодальные базы данных. Их общее количество в мире составляет около десятка. В основном они были созданы за рубежом, например в США, Германии, Китае, но в их числе есть и российская база под названием RAMAS, созданная в Москве несколько лет назад. Для обучения моделей мы использовали все вышеперечисленные массивы информации, — говорит А.А. Карпов. — В основном обучение и тестирование системы проводилось на готовых базах данных, потому что нам нужны размеченные материалы — такие, где указано, что первая запись показывает эмоцию радости, вторая — нейтральное состояние, третья — грусть и т.д. Дело в том, что восприятие эмоций — довольно тонкая область: например, один человек может посчитать, что его оппонент спокоен, а другой — воспринять это как печаль. Таким образом, важно, чтобы несколько наблюдателей сошлись во мнении, что тот или иной материал соответствует определенной эмоции. Поэтому в разметке данных для информационных баз участвуют от трех до пяти человек-аннотаторов, которые в процессе обсуждения выявляют доминирующую эмоцию в записи. Иначе разметка данных получится очень субъективной».

Для испытаний получившейся системы ученые отобрали материалы из всех баз данных, использовавшихся для тренировки алгоритмов. Сегодня средняя точность распознавания базовых эмоций с помощью MASAI достигает 75–80%. Впрочем, считать настроение оппонента с абсолютной точностью неспособен даже живой человек.

Участие в тематических международных конкурсах позволяет исследователям заключить, превосходит ли проект по качеству зарубежные аналоги.

В 2025 г. система MASAI победила в конкурсе по распознаванию составных эмоций (например, когда человек испытывает радость и удивление одновременно) на соревновании при международной конференции по компьютерному зрению ICCV 2025.

Фото: wayhomestudio / фотобанк Freepik

«Мы сопоставляем нашу разработку с зарубежными системами — например, англоязычными, — отмечает А.А. Карпов. — В частности, мы участвуем в международных соревнованиях по распознаванию эмоций. В прошлом году мы представляли нашу технологию на девятом международном соревновании ABAW при престижной международной конференции по компьютерному зрению ICCV 2025. Один из конкурсов этого соревнования был посвящен распознаванию составных эмоций. В этих случаях аннотаторы приходят к заключению о доминировании сразу двух состояний: например, сначала проявляется одна эмоция, но затем она быстро перерастает в другую. Так, человек может выглядеть печально-удивленным или радостно-удивленным. И мы победили в этом соревновании в 2025 г. Таким образом, можно считать, что наша разработка превосходит зарубежные аналоги».

По словам А.А. Карпова, один из способов повысить качество определения эмоций с помощью новой системы — дополнительное обучение, но уже на конкретном языке: например, ИИ можно адаптировать только для русской речи, проведя дополнительное обучение на массивах русскоязычных данных.

Примечательное дополнение о языках: в процессе разработки MASAI ученые провели отдельное интересное исследование, посвященное кросс-языковому и кросс-корпусному распознаванию эмоциональных явлений. В этих случаях ИИ обучали на материалах, характеризующих носителей одного языка (например, английского), а затем проверяли точность, с которой он определял эмоции людей, говорящих на другом языке (например, на русском).

«В этом случае точность немного падает, но в целом у представителей европейской культуры многие эмоции проявляются более или менее одинаково, — объясняет А.А. Карпов. — В то же время, например, возникают некоторые сложности с китайским языком, поскольку у жителей Востока иной менталитет и они проявляют некоторые эмоции по-другому. Например, мы столкнулись с тем, что представители европейской культуры обычно вскрикивают от испуга, а азиатской — как правило, замирают и молчат».

На этом работа над технологией не заканчивается. Как рассказывает Алексей Анатольевич, в будущем система, вероятно, будет задействовать еще больше модальностей: например, сможет анализировать эмоции по частоте сердечных сокращений, определяемой с помощью электрокардиограммы.

Возможно, что в будущем новая система будет задействовать еще больше модальностей: например, сможет анализировать эмоции по частоте сердечных сокращений.

Источник изображения: nexusplexus / фотобанк 123RF

«Для нас желательно расширить набор информации для обучения системы. Я уже говорил, что наш комплекс алгоритмов, как и другие существующие в мире разработки, не обеспечивает стопроцентную точность анализа психоэмоциональных состояний. Текущий показатель в 75–80% — уже достойный результат. Но мы стремимся достичь большего, а для этого нужно набрать дополнительные обучающие данные, — заключает А.А. Карпов. — Поэтому мы планируем создать собственную многомодальную базу данных для подготовки моделей. В качестве источника материалов можно будет использовать видеохостинги, такие как “VK Видео” и другие. Разумеется, чтобы записи можно было использовать для обучения, их будет необходимо предварительно разметить».

Разработки в области ИИ, распознающего эмоции, очень актуальны. Их ведут и другие российские научные команды. Например, группа исследователей из лаборатории ИИ «Сбера», института AIRI и Московского физико-технического института представила алгоритм CA-SER для высокоточного распознавания эмоций по речи: ее особенностям, интонации, громкости голоса. А ученые из Национального исследовательского университета «Высшая школа экономики» разработали нейросеть, определяющую эмоции человека и его интерес к происходящему по видеоизображению. Созданная система может успешно работать даже на телефоне и предназначена для анализа внимательности участников видеоконференций — например, студентов на дистанционном обучении.

Источники

Комментарии А.А. Карпова

СПб ФИЦ РАН. В СПб ФИЦ РАН разработали систему распознавания эмоций человека по видео и речи

СПб ФИЦ РАН. Лаборатория речевых и многомодальных интерфейсов. Проекты. Интеллектуальная система многомодального распознавания аффективных состояний человека

ТАСС. Улучшено распознавание эмоций по голосу с помощью ИИ

НИУ ВШЭ. Российские ученые научили искусственный интеллект анализировать эмоции участников онлайн-мероприятий

Источник изображения на превью: freepik / фотобанк Freepik

Источник изображения на главной странице: freepik / фотобанк Freepik

Источники изображений в тексте: из личного архива А.А. Карпова, freepik / фотобанк Freepik, freepic.diller / фотобанк Freepik, KamranAydinov / фотобанк Freepik, из личного архива разработчиков системы, freepik / фотобанк Freepik, freepik / фотобанк Freepik, предоставлено разработчиками системы, wayhomestudio / фотобанк Freepik, nexusplexus / фотобанк 123RF.

Статья подготовлена при поддержке Российской академии наук