Искусственный интеллект представляет особый интерес для ученых-правоведов России и мира. Что такое компьютерный разум с точки зрения юриста — рукотворный объект или все же «электронное лицо» и может ли измениться взгляд на ИИ с течением времени? Как «умные» программы помогают творить законы и вершить суд? Чем интересны создаваемые при участии российских правоведов нормативные документы в области высоких технологий — Цифровой кодекс и Федеральный закон о технологической политике? О том, как развивается российское и мировое законодательство в области искусственного интеллекта, рассказывает директор Института законодательства и сравнительного правоведения при Правительстве РФ, заместитель президента РАН академик Талия Ярулловна Хабриева.

Талия Ярулловна Хабриева — ученый-правовед, специалист в области конституционного права. Директор Института законодательства и сравнительного правоведения при Правительстве РФ, доктор юридических наук, профессор, академик, член президиума РАН, заместитель президента РАН. Действительный член Международной академии сравнительного права, почетный член Национальной академии наук Республики Казахстан, почетный профессор Института права Китайской академии общественных наук, почетный член академии наук Республики Татарстан. Заслуженный юрист РФ и Республики Татарстан, заслуженный деятель науки РФ, обладатель юбилейной медали «300 лет Российской академии наук» (2024) и золотой медали им. М.М. Сперанского РАН (2015), кавалер ордена «За заслуги перед Отечеством» II, III и IV степеней (2023, 2010 и 2008), ордена Александра Невского (2015), ордена Почета (2005), ордена Дружбы (2013).

Институт законодательства и сравнительного правоведения при Правительстве РФ — старейший в России и СНГ многопрофильный центр правовой науки, специализирующийся на широком спектре теоретических и научно-прикладных работ. Институт занимается научно-правовым обеспечением деятельности правительства РФ и других высших органов государственной власти.

— С какими ключевыми проблемами сталкивается правовая идентификация искусственного интеллекта в России? Для каких из них уже существуют решения?

— Проблемы, с которыми имеют дело в этой области разработчики и ученые-практики, общие для всех стран. В первую очередь следует назвать разнообразие обсуждаемых технологий: все говорят о слабом и сильном искусственном интеллекте, об ИИ, обучающемся на данных низкого либо высокого качества. Эти названия условны, но очевидно, что у разных видов искусственного интеллекта есть свои особенности. Так, технологии слабого ИИ предназначены для решения одной задачи или небольшого их комплекса: например, для компьютерной игры, виртуальной игры в шахматы или распознавания речи. Совершенно другими отличительными чертами обладают технологии сильного искусственного интеллекта — самообучающегося, понимающего свои мысли. Говорят, что в будущем подобные программы даже смогут осознавать себя как личность.

Талия Ярулловна Хабриева рассказала нам о проблемах правовой идентификации искусственного интеллекта и развитии законодательства, регулирующего сферу разработки и применения высоких технологий.

Фото: Елена Либрик / «Научная Россия»

Во-вторых, отдельную проблему представляют формы проявления технологий искусственного интеллекта во взаимодействии с человеком, разнообразие которых также огромно. Например, есть «самостоятельные» программы, такие как чат-бот ChatGPT на основе нейросети, который очень впечатляет пользователей тем, что может разговаривать с собеседником как живой человек. В то же время существует и другая разновидность ИИ, используемая в технических системах: например, программы для беспилотных летательных аппаратов и транспорта.

В-третьих, разные виды технологий искусственного интеллекта по-разному проявляют себя с точки зрения социальных эффектов, следовательно, могут нести разные риски при их использовании. Иными словами, различные «умные» программы способны причинять пользователям разный ущерб. Рассмотрение этого вопроса — еще одна проблема для правоведов.

В-четвертых, технологии искусственного интеллекта применяются в большом разнообразии сфер. Например, ИИ может использоваться в публичном управлении — в предоставлении государственных услуг. Мы с вами как москвичи пользуемся подобными сервисами. Помимо этого, технологии искусственного интеллекта задействованы в работе таможенной службы, в медицине, транспорте, банковском деле и многих других областях. Охват сфер, где используется ИИ, очень широк, и это также ведет к различиям в степени риска при работе с искусственным интеллектом: в разных отраслях применение «умных» программ может причинить различный по серьезности ущерб.

Но, на мой взгляд, ключевая сложность идентификации искусственного интеллекта юристами — сам правовой феномен этой технологии, так как она очень многозначна. Например, ИИ рассматривается как объект субъективного права, подчиняющийся определенному правовому режиму, — так же как любая другая вещь, созданная человеком, хотя если программа не заключена в машину, то мы не можем ее потрогать.

Приведу пример. Существует так называемая система электронного судьи. Она используется в Китае, в России пока применяются только элементы этой системы. Данная программа готовит для судьи необходимые документы, материалы правовой квалификации. Эта разработка также рассматривается вышеописанным образом: она идентифицируется как объект правообладания (у нее есть собственник), у этой системы существует оператор и использование технологии подчиняется определенному правовому режиму, позволяющему применять «электронного помощника» в судебной деятельности.

У искусственного интеллекта есть и другая сторона: он может играть инструментальную роль. В этой области у «умных» программ большой потенциал применения, реализуемый уже сейчас. Например, в сфере права ИИ помогает собирать информацию для формирования воли законодателя, другими словами, задействуется в разработке новых правовых норм. Применение ИИ в законотворчестве открывает большие перспективы. Пока мы называем подобные разработки нашим вспомогательным инструментом, но, вероятно, в будущем они могут стать и основным. Инструментальная функция нейросетей — еще один пример дисперсии сущности феномена технологий ИИ.

Полагаю, что самое необычное для юристов — это предложение ввести самостоятельную правосубъектность искусственного интеллекта, то есть обозначить ИИ как самостоятельный субъект правоотношений. Эту идею можно обнаружить в правовой доктрине в области регулирования отношений, связанных с ИИ, и не только в ней. Для юристов это звучит несколько странно, но тем не менее такие предложения существуют. Речь идет в том числе о том, чтобы предоставлять юнитам ИИ статус гражданства. Первый юридический казус подобного рода уже произошел в 2017 г. в Саудовской Аравии: подданство королевства получила робот София. Получается, что искусственный интеллект, помещенный в этого робота, обладает большими правами, чем женщины королевства: он может разговаривать с мужчинами, не носить абайю. Это, конечно, курьез.

Тем не менее подобные подходы тоже разрабатываются. В 2017 г. Еврокомиссия приняла рекомендацию в отношении робототехники, в которой допускает возможность наделения роботов с использованием технологий ИИ статусом электронного лица. В России у концепции электронного лица также есть сторонники. Стоит добавить, что правовая доктрина уже предлагает концепцию гражданско-правовой и даже уголовно-правовой ответственности ИИ. Размышляя о том, во что это разовьется в будущем, можно констатировать, что пока законодательство в области регулирования сферы ИИ (которое уже довольно заметным образом расширяется и в России, и за рубежом) по этому пути не идет.

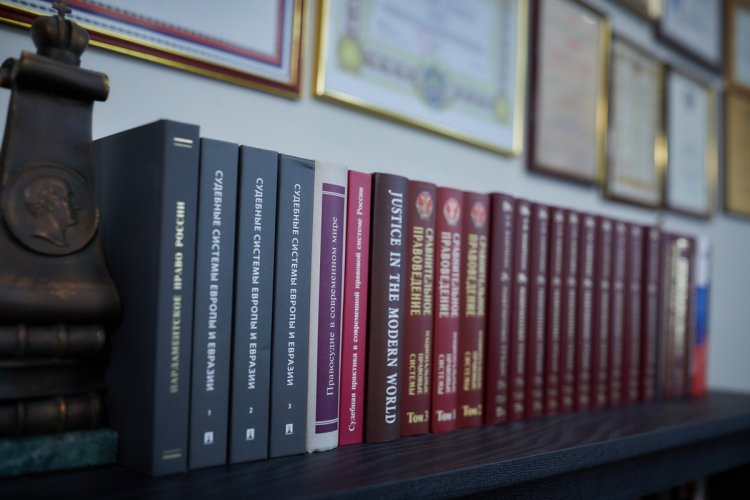

В кабинете Талии Ярулловны Хабриевой в Институте законодательства и сравнительного правоведения при Правительстве РФ.

Фото: Елена Либрик / «Научная Россия»

Помимо дисперсии правовой сущности феномена искусственного интеллекта, другая проблема, с которой сталкиваются юристы в области идентификации подобных технологий, — разные подходы к определению ИИ. Кто-то называет ИИ технологией, кто-то — комплексом технологий, кто-то — машинно-аппаратным комплексом и т.д. Соответственно, в законодательстве уже появились разные дефиниции для ИИ. Например, в Москве в 2020 г. был принят Федеральный закон № 123, связанный с проведением в столице эксперимента по созданию условий для разработки и использования технологий ИИ. В нем искусственный интеллект обозначается как «комплекс технологических решений» с определенными характеристиками. Уже существующие ГОСТы определяют ИИ как «моделируемую интеллектуальную деятельность» — тоже с особыми отличительными признаками.

Интересно, что в Концепции правового регулирования технологий искусственного интеллекта, утвержденной распоряжением правительства РФ до 2024 г., содержится рекомендация пока не давать технологиям ИИ общего определения, применимого ко всем сферам. На мой взгляд, это разумно. Тем не менее легальные дефиниции для ИИ уже существуют и не совпадают друг с другом, что тоже представляет проблему для правоведов. Но это сложности юридико-технического плана, и я думаю, что мы с ними справимся: главное — определиться с подходом к рассмотрению технологий ИИ. Здесь многое зависит от того, какую цель ставит перед собой государство.

— В вашем докладе «Проблемы правовой идентификации искусственного интеллекта», который был представлен на заседании президиума РАН 12 марта, упоминается необходимость переноса норм этики в правовые нормы, регулирующие работу ИИ. На ваш взгляд, какие этические нормы, связанные с ИИ, необходимо перенести в область права в первую очередь? Какие нормы этики уже перекочевали в правовые документы?

— Действительно, я констатировала в докладе, что легализация этики в области технологий ИИ уже происходит. Если еще недавно мы говорили о том, что стоим на своеобразной развилке — сохранять этическое регулирование сферы ИИ или переходить к правовому, — то теперь этот этап уже пройден и во всем мире наблюдается нарастание правового регулирования.

Почему так происходит? Когда формируется любая новая отрасль, сначала непонятно, какова будет динамика развития отношений между ее участниками и потребуют ли они правового регулирования. Поэтому в действие вступают этические нормы: сначала неформально, в дальнейшем они некоторым образом формализуются. Так, в 2017 г. свои рекомендации в отношении работы с ИИ приняли страны «Большой двадцатки». В 2019 г. глобальные стандарты в области ИИ были приняты ЮНЕСКО, в том же году Организация экономического сотрудничества и развития (ОЭСР) приняла руководящие принципы по ИИ и соответствующие рекомендации странам по национальной политике и т.д. В России тоже существует свой кодекс этики в области ИИ: на сегодня к нему присоединились более 190 компаний, в числе которых 15 зарубежных.

Таким образом, право в силу свойственных ему консерватизма и инерции довольно долго не реагировало на развитие отношений в области искусственного интеллекта. Но сейчас глубина погружения общества в «цифровую матрицу» настолько велика и риски при использовании обсуждаемых технологий возрастают так заметно, что возникла необходимость в правовом регулировании этих отношений. И основным источником для норм права в области ИИ выступают именно этические принципы и нормы. Приведу пример: в 2019 г. был издан указ президента РФ «О развитии искусственного интеллекта в Российской Федерации». В нем были в том числе использованы международные этические принципы и стандарты, которые я упоминала ранее. В частности, речь идет о гуманистической направленности разработок, уважении автономии и свободы воли человека, безопасности, а также об открытости, защите персональных данных и ряде других. Дословно эти принципы не совпадают, но можно говорить о том, что в целом в указе приведены те же идеи, что были сформулированы во второй половине текущего уходящего десятилетия.

«Самое значимое для правового регулирования в области ИИ — степень делегирования функций человека нейросети и степень контроля человека над программой», — академик Т.Я. Хабриева.

Фото: Елена Либрик / «Научная Россия»

Можно утверждать, что российское законодательство постепенно воспринимает упомянутые этические принципы и включает их на уровень норм права. Например, в число давно действующих нормативных актов нашей страны входят Федеральный закон «Об информации, информационных технологиях и о защите информации» и Федеральный закон «О защите персональных данных». В них также отражены названные мной принципы регулирования области ИИ, такие как прозрачность, объяснимость, безопасность.

Что касается будущего пути развития законодательства в сфере искусственного интеллекта, я полагаю, что предстоит не столько дальнейшее погружение в закон обсуждаемых этических принципов, уже оправдавших себя и сыгравших свою роль, сколько формирование уже полноценных правовых основ создания, внедрения и применения технологий ИИ. В настоящее время необходимо разрабатывать не столько принципы, сколько конкретные механизмы по установлению обязательных требований к разработке и применению «умных» программ и в случае их нарушения купировать возникающие риски и при необходимости компенсировать возмещение вреда здоровью и имуществу. Именно для этого и необходимо регулирование сферы ИИ на основе правовых императивов. В данный момент как раз происходит формирование таких механизмов.

Подчеркну, что самое значимое для правового регулирования в области ИИ — степень делегирования функций человека нейросети и степень контроля человека над программой, потому что в зависимости от данных факторов либо низок, либо высок риск причинения вреда человеку, имуществу, обществу, государству. Это крайне важно. Стоит добавить, что уровень риска во многом зависит от сферы применения нейросетей. Скажем, в компьютерных играх эта проблема не столь остра, главное, чтобы не было игровой зависимости. А если говорить об использовании ИИ, например, в медицине, на транспорте, в предоставлении государственных услуг, здесь риски заметно возрастают.

— Вы отмечали в докладе, что Институт законодательства и сравнительного правоведения разработал модели правового регулирования важнейших отношений в области ИИ. Расскажите, пожалуйста, об этом немного подробнее. Какие виды отношений затрагивают эти модели? Какие основные принципы в них зафиксированы?

— Наш институт, отметивший столетие в прошлом году, — старейший научно-исследовательский институт в области права в России и СНГ (но есть основания полагать, что и в Европе) — занимался проблемами научно-технического прогресса еще в советские годы. Здесь рассматривались вопросы применения первых электронно-вычислительных машин (прообразов нынешних компьютеров): использования их возможностей в народно-хозяйственном планировании, систематизации законодательства. В свое время в институте даже был создан специальный Центр правовой информации: для нас изготовили огромную электронно-вычислительную машину, занимавшую несколько этажей. Таким образом, регулирование применения новаторских разработок всегда было тематикой института. И основная идея, которой всегда следовал наш коллектив, — антропоцентричная модель использования новых технологий. Этот принцип заключается в том, что технологический прогресс всегда должен идти на пользу человеку. И на нашем пути мы неизменно сохраняем приверженность этой идее.

Если говорить о моделях правового регулирования отношений в области ИИ, я бы начала с той, которая сформировалась в связи с внесением поправок в Конституцию в 2020 г. Мы одними из первых в мире сумели предложить конституционные параметры для развития научно-технологической политики, сохранения научного потенциала, а также создания и внедрения новых технологий. Кстати, ИЗиСП осуществлял научно-правовое сопровождение конституционной реформы: я была сопредседателем рабочей группы по подготовке поправок, и самым большим «десантом» от научных учреждений в ее составе были наши сотрудники.

Разработанная нами модель, включая обоснование и юридические формулировки, по сути, создает новую государственную функцию: поддержку научно-технологического развития Российской Федерации, сохранение и развитие ее научного потенциала. Соответствующие поправки внесены в статьи 71, 114 Конституции, где впервые появились нормы государственной поддержки научно-технологического прогресса Российской Федерации, сохранения и развития ее научного потенциала. Впервые зафиксирована обязанность правительства также поддерживать прогресс науки и технологий. Еще одно важное новшество, в котором мы тоже во многом опередили другие страны, — норма, зафиксированная в пункте «м» статьи 71-й Конституции, утверждающая принцип безопасности применения новых информационных технологий. Обозначены главные субъекты, безопасность которых необходимо обеспечивать в связи с применением инноваций: человек, общество и государство. Можно предположить, что эта норма подразумевает и защиту бизнеса.

Таким образом, появилась конституционная база для дальнейшего правового регулирования в области искусственного интеллекта. В законодательстве были определены принципы регулирования, применимые ко всем отношениям, связанным с новыми технологиями, и всем их участникам (разработчику, владельцу, оператору, пользователю), в том числе главный принцип — обеспечение безопасности. Это позволит купировать риски, которыми использование ИИ грозит главным субъектам правоотношений: человеку, обществу и государству.

Этой модели следуют и Концепция технологического развития России до 2030 г., и проект Федерального закона о технологической политике РФ. О законе, я полагаю, мы еще поговорим; на него возлагает большие надежды Российская академия наук. Указ от 7 мая 2024 г. «О национальных целях развития Российской Федерации на период до 2030 г. и на перспективу до 2036 г.», изданный президентом России В.В. Путиным после инаугурационной речи, также соответствует идеям указанной конституционной модели как по целям, так и по параметрам развития страны.

Другие правовые модели, обоснованные учеными, имеют более конкретный характер. Например, мы предложили модель солидарной ответственности разработчиков, владельцев платформ и пользователей, например, за распространение размещаемой на ресурсах заведомо ложной информации. Кстати, в январе 2024 г. на моей встрече с председателем правительства РФ М.В. Мишустин высоко оценил предложенные нами подходы и рекомендовал развивать их совместно с Минцифры. Надеюсь, что эти и другие правовые наработки будут использованы при подготовке Цифрового кодекса и сопутствующих актов.

Ученые института немало продвинулись в вопросах регулирования отношений в области ИИ. Речь идет и об отдельных правовых институтах, которые во многом завязаны на динамику развития гражданского права в связи с созданием и использованием новых технологий. В рамках этой темы есть что обсудить, но на самом деле это большой перечень.

– Ваш институт принимает активное участие в работе над двумя важными документами в области информационных технологий: уже названным вами Цифровым кодексом и Федеральным законом о технологической политике РФ. Расскажите, пожалуйста, немного подробнее об этих документах. На какие их особенности вам хотелось бы обратить внимание и известны ли примерные сроки вступления этих документов в действие?

— Сразу скажу, что о сроках принятия можно говорить только предположительно, но есть возможность определить степень готовности.

Т.Я. Хабриева — заслуженный деятель науки РФ и обладатель многих высоких наград.

Фото: Елена Либрик / «Научная Россия»

Мы действительно принимали участие в разработке закона о технологической политике. Проект неоднократно рассматривался на специальных совещаниях в правительстве РФ, в том числе у вице-премьера А.Р. Белоусова, который в свое время сказал, что это в бóльшей степени не закон, а манифест. По сути, в нем воплощена Концепция технологического развития России до 2030 г. — и этим все сказано. Другими словами, закон имеет очень общий характер, и в первую очередь он нацелен на то, чтобы определить основные направления технологического развития страны, а также условия для сохранения технологического суверенитета. В то же время он играет очень важную роль, так как определяет компетенцию разных участников этого процесса: распределяет обязанности между органами Российской Федерации, субъектов страны, муниципальными органами, а также Российской академией наук, иными государственными уполномоченными организациями и публичными компаниями, участвующими в разработке и продвижении инноваций. Главная задача закона — убрать препятствия, не позволяющие разрабатывать новые технологии и быстро внедрять их в эксплуатацию. Я называю этот подход «компетенционный» и полагаю, что он правильный.

Стоит обратить внимание и на другие значимые аспекты Закона о технологической политике. В нем впервые предусматриваются новые организационно-правовые механизмы, связанные с созданием и внедрением технологий: речь идет о разных формах финансовой, налоговой, экспертной и кадровой поддержки разработок. Кроме того, закон включает организационно-правовые меры, связанные с технологической координацией — построением планов создания технологий (в том числе сквозных), а также их комплексов. Помимо этого, в новом законе определяется необходимый понятийный аппарат.

Итак, Закон о технологической политике во многом будет базовым — как я уже говорила словами Андрея Рэмовича Белоусова, своеобразный «закон-манифест». Для нас работа над данным законопроектом во многом оказалась в новинку: такую задачу правоведам еще не доводилось решать. Думаю, этот закон внесет важный вклад в правовое регулирование в области высоких технологий и искусственного интеллекта в частности.

Следует обратить внимание еще на одну деталь Закона о технологической политике. Среди мер поддержки технологического развития в документе вводится новое понимание эффективности финансирования научных проектов — закладывается право исследователей и изобретателей на высокий риск, защищающее их в случае, если средства на разработку были потрачены, а открытие по тем или иным причинам не совершилось. Новые формы эффективности финансирования очень важны, потому что позволяют ученым избежать ответственности, если им не удалось реализовать проект по намеченному плану. Подводя итог, могу подтвердить, что Закон о технологической политике может помочь решить насущные задачи в сфере научно-технологического развития страны и занять свое место в современной системе регулирования новых технологий.

Что касается Цифрового кодекса, здесь дела обстоят несколько сложнее. Мы участвовали в подготовке этого документа еще на этапе разработки его концепции. Изначально мы очень критически отнеслись к идее кодификации законодательства в сфере информационных, цифровых технологий, потому что данный процесс всегда юридически очень сложен, но не всегда необходим. Да и название «Цифровой кодекс» не совсем научное и с юридической точки зрения не вполне подходящее. С другой стороны, понятие «цифровой» уже прочно вошло в правовой обиход: например, уже используются «цифровые права». В настоящее время цифровые кодексы разрабатываются в странах Евразийского экономического союза, Содружества Независимых Государств. Проекты подобных кодексов уже готовятся в Киргизии, Казахстане, с недавнего времени — в Азербайджане. Это говорит о том, что, судя по всему, время для разработки данных документов пришло.

По нашему предложению Министерством цифрового развития были внесены изменения в предмет регулирования и скорректирована основная идея проектируемого кодекса. Это позволит развести положения нового документа с уже действующим законодательством во избежание противоречий. Помимо этого, мы предложили состав сфер деятельности, подлежащих кодификации (которые будут регулироваться Цифровым кодексом). Полагаю, что был полезен и представленный нами анализ зарубежного опыта систематизации и кодификации законодательства об информации и цифровых технологиях.

Разработка текста российского Цифрового кодекса пока не начиналась, поэтому в полной мере значение инициативы пока сложно оценить. Но уже можно сказать, что главная задача документа — систематизация норм в обсуждаемой области. В заключительную версию концепции кодекса, направленную министерством в институт, включены более конкретные сюжеты в сфере цифровых технологий, подлежащие нормативному регулированию. В их числе — и регламентация процесса создания, обучения и использования искусственного интеллекта.

Посмотрим, как будет развиваться работа над кодексом в дальнейшем. Пока проект в основном находится на стадии обсуждения главных подходов. В то же время для него уже созданы некоторые образцы, отдельные правовые модели. На мой взгляд, разработчикам документа нужно будет обратить отдельное внимание на регулирование вопросов, касающихся цифровых платформ и цифровых экосистем: в этих областях есть большие проблемы.

В заключение я хочу поблагодарить за интерес к этой теме не просто как к модному веянию, а как к вопросу, который заботит умы не только молодого поколения, но и всего общества, включая правоведов.

Мне очень понравилось, как описал проблемы в области правовой идентификации искусственного интеллекта один из моих коллег, заместитель директора нашего института А.С. Емельянов. Он сравнил работу современных российских и зарубежных юристов с притчей про слона и семерых мудрецов: каждый натыкался на зверя в кромешной темноте и описывал его — кто-то говорил, что это дерево, кто-то утверждал, что это диван, и каждый был по-своему прав. Так же и мы, изучая феномен ИИ, нащупываем разные стороны его сущности и, исходя из своих наблюдений, даем этой технологии различные определения и пытаемся соответствующим образом идентифицировать ее уже на законодательном уровне. Однако я думаю, что уже в ближайшем будущем мы сможем представить этого «слона» как целое и получим ожидаемый от нас социальный эффект.

Интервью проведено при поддержке Министерства науки и высшего образования РФ