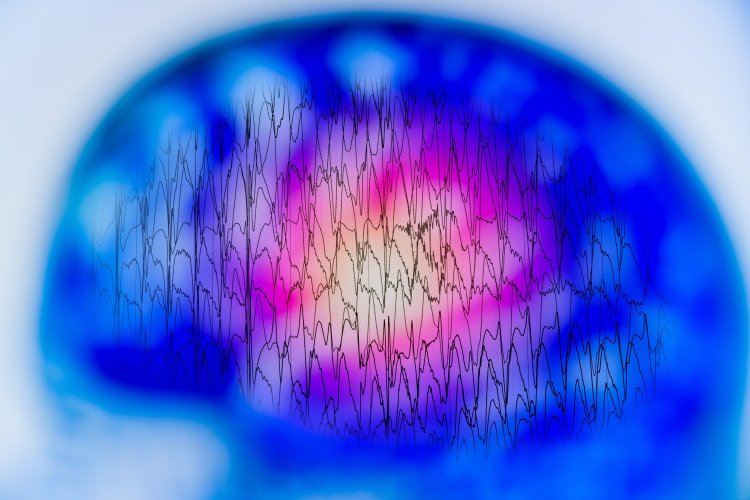

Исследователи Санкт-Петербургского федерального исследовательского центра РАН (СПб ФИЦ РАН) при помощи нейросети научились автоматически распознавать эмоциональное состояние человека по сведениям электроэнцефалограммы (ЭЭГ) головного мозга. Результаты исследования опубликованы в научном журнале Big Data and Cognitive Computing (Q1). Они найдут применение в цифровых помощниках для охраны психологического здоровья человека в режиме реального времени.

Сегодня значительное количество объектов транспортной, промышленной и оборонной инфраструктуры контролируется и функционирует при помощи операторов, водителей или единых информационных центров с целой командой специалистов. От психофизиологического состояния часто зависит способность обеспечить безопасность таких объектов.

Для регулярного мониторинга столь важных специалистов сейчас активно внедряются цифровые помощники, в основе которых лежат нейросети, использующие для распознавания внешние проявления личности на видеозаписях: выражение лица, речь, язык тела и прочее. Однако эти методы имеют ограничения, в том числе зависимость от визуальных или слуховых стимулов, на которые могут влиять условия освещения, фоновый шум или культурные различия в выражении эмоций. Поэтому для повышения качества работы цифровых помощников исследователи привлекают широкий комплекс разнородных данных.

Так, ученые СПб ФИЦ РАН уже много лет ведут разработки программного обеспечения для оценки опасных состояний человека, которое учитывает в том числе и эмоциональную нестабильность. Мониторинг ведется на основе анализа фото, видео, пульса и даже особенностей моргания глаз.

«В новом исследовании мы решили использовать еще один тип данных и обучили нейросеть по данным ЭЭГ с высокой точностью распознавать, какие эмоции человек испытывает в режиме реального времени: позитивные, негативные или нейтральные. В будущем наше решение может быть интегрировано в устройство для неинвазивного (т.е. без повреждения тканей организма) мониторинга психофизиологического состояния пользователей, в том числе тех, от кого зависит работоспособность критической инфраструктуры», — рассказывает старший научный сотрудник лаборатории автоматизированных систем СПб ФИЦ РАН Алексей Кашевник.

Нейросетевая модель была обучена распознаванию эмоций на двух больших базах данных ЭЭГ (FACED и SEED), которые находятся в открытом доступе для разработчиков. В целом, в них содержится обезличенная информация о мозговой активности более 130 человек различного пола и возраста.

Для проверки корректности распознавания ученые самостоятельно собрали небольшой набор данных еще 16 человек при помощи компактного носимого на голове устройства для записи ЭЭГ. Параллельно они записали на видео этих респондентов для сравнения эффективности двух методов: распознавания эмоций по электроэнцефалограмме и по видеоданным.

«Одна из главных проблем, с которой мы столкнулись, — необходимость учета различных паттернов ЭЭГ у разных респондентов. Мозговая активность каждого участника уникальна, что приводит к различиям в сигналах ЭЭГ даже при ощущении одних и тех же эмоциональных состояний. Несмотря на эти трудности, предложенная модель анализа ЭЭГ показала многообещающие результаты в классификации валентности эмоций. Точность составила в среднем от 70% до 80% в зависимости от человека», — отмечает Алексей Кашевник.

Исследование проведено в рамках выполнения госзадания Минобрнауки России.

Информация предоставлена СПб ФИЦ РАН

Источник фото: ru.123rf.com