Новая модель машинного обучения может позволить роботам понимать отношения предметов так же, как люди, сообщает Массачусетский технологический институт.

Когда мы рассматриваем свое окружение, мы видим объекты и считываем отношения между ними. На столе перед нами может лежать ноутбук, который находится слева от телефона, который расположен перед монитором компьютера.

Многие модели глубокого обучения с трудом видят мир таким образом, потому что не понимают запутанных отношений между отдельными объектами. Не понимая эти взаимосвязи, робот, предназначенный, например, для помощи на кухне, будет испытывать трудности с выполнением такой команды, как «возьмите лопатку, которая находится слева от плиты, и поместите ее на разделочную доску».

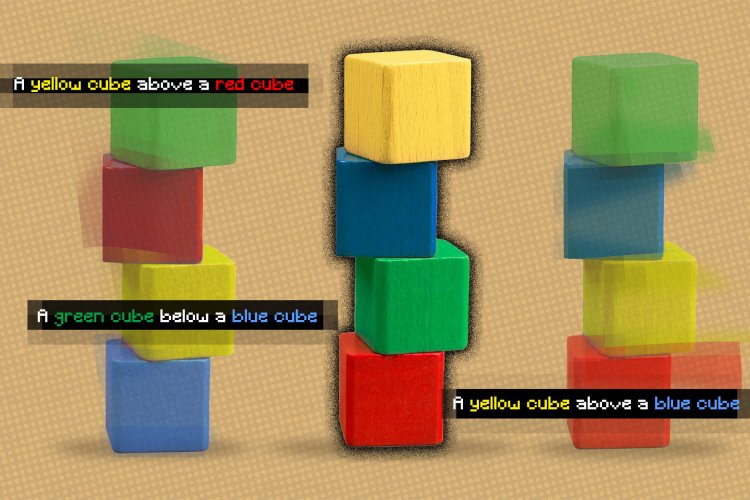

Пытаясь решить эту проблему, исследователи Массачусетского технологического института (США) разработали модель, которая понимает основные отношения между объектами в сцене. Их модель сначала определяет расположение двух предметов относительно друг друга, а затем объединяет эти представления для описания всей сцены. Это позволяет системе генерировать более точные изображения из текстовых описаний, даже если сцена включает в себя несколько объектов, которые расположены по-разному.

«Когда я смотрю на стол, я не могу сказать, что в точке с координатами XYZ есть объект. Наш мозг так не работает. В нашем сознании, когда мы понимаем сцену, мы действительно понимаем ее, основываясь на отношениях между объектами. Мы думаем, что, построив систему, которая может понимать отношения между объектами, мы могли бы использовать ее для более эффективного управления и изменения нашей среды», – говорит Илун Ду, аспирант Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института, ведущий автор статьи.

Разработанная модель ИИ может создавать изображение сцены на основе текстового описания объектов и их взаимосвязей, например: «Деревянный стол слева от синего стула. Красный диван справа от синего стула».

Система разбивала эти предложения на две более мелкие части, описывающие каждую индивидуальную взаимосвязь («деревянный стол слева от синего стула» и «красный диван справа от синего стула»), а затем моделировала каждую часть по отдельности. Затем эти части объединялись – и вырисовывалась картинка сцены.

Разбивая предложения на более короткие части для каждого взаимоотношения, система может комбинировать их различными способами, чтобы лучше адаптироваться к описаниям сцены, которых она раньше не видела.

«Другие системы будут рассматривать все отношения как единое целое и генерировать изображение за один раз из описания. Однако такие подходы терпят неудачу, когда у нас есть <…> описания с большим количеством отношений, поскольку эта модель не может действительно адаптировать один снимок для создания изображений, содержащих большее количество взаимосвязей. Однако, когда мы составляем отдельные, более мелкие модели вместе, мы можем моделировать большее количество взаимосвязей и адаптироваться к новым комбинациям», – говорят авторы работы.

Система также работает наоборот: по изображению она может находить текстовые описания, которые соответствуют отношениям между объектами в сцене. С ее помощью даже можно редактировать изображения, переставляя объекты в сцене так, чтобы они соответствовали новому описанию.

Исследователи сравнили, как работает их модель и другие методы глубокого обучения. В каждом случае новая модель превзошла базовые показатели. Даже когда системе предлагали две сцены, которые описывали одну и ту же картинку, но по-разному, модель смогла понять, что сцены на самом деле одинаковые.

Ученые также попросили людей оценить, соответствуют ли сгенерированные изображения исходному описанию сцены. 91% участников пришли к выводу, что в наиболее сложных примерах, с тремя отношениями в описании, новая модель работает лучше старых.

Хотя эти первые результаты обнадеживают, разработчики хотели бы увидеть, как их модель работает на более сложных реальных изображениях с шумным фоном и объектами, которые перекрывают друг друга.

В конечном итоге ученые хотели бы включить свою модель в робототехнические системы, что позволит роботу определять отношения между объектами из видео, а затем применять эти знания для управления объектами в реальном мире.

Новый метод пригодится в ситуациях, когда промышленные роботы должны выполнять сложные многоступенчатые задачи: например, складывать предметы или собирать технику. Это также приближает науку на один шаг к тому, чтобы машины могли взаимодействовать с окружающей средой так же (или почти так же), как люди.

[Фото: Jose-Luis Olivares, MIT, and iStockphoto]