Компьютерная система Deep-Q-Network, разработанная английским стартапом DeepMind, стабильно набирает в классических видеоиграх на 20-30% больше очков, чем человек. О том, как им удалось этого добиться, авторы программы рассказали в своей статье, опубликованной в журнале Nature. Вкратце о новом достижении в области кибернетики рассказывает сайт журнала Science.

Небольшой стартап DeepMind основал полгода назад в Лондоне Демис Хассабис (Demis Hassabis), компьютерщик-вундеркинд и бывший дизайнер компьютерных игр. Всего через несколько месяцев Хассабис показал первые наработки своей команды на международной выставке в Париже, после чего DeepMind был куплен Google за $500 миллионов. И вот теперь, уже под эгидой IT-гиганта, он представил свою самообучающуюся систему искусственного интеллекта.

В основу работы компьютерной системы Deep-Q-Network (сокращенно DQN) положено два принципа. Первый — это принцип глубоких нейронных сетей. Это сети из десятков тысяч «нервных клеток», подобных тем, что действуют и в нашем мозгу, только у искусственного интеллекта вместо живых нейронов используются компьютерные элементы. Второй принцип — обучение с подкреплением, которое используется, например, в дрессировке животных. Его идея в том, что интеллект путем многих проб и ошибок учится совершать именно те действия, которые приносят максимальный положительный эффект (т.е. «подкрепление»).

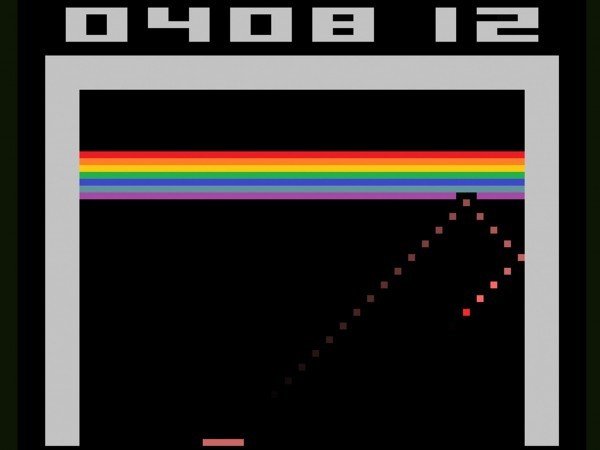

Возможности Deep-Q-Network проверили на 49 классических компьютерных играх компании Atari, таких как «Арканоид» или «Вторжение из космоса». Эти игрушки, говорит Хассаби, являются как раз идеальными задачами — они не слишком просты, но и не слишком сложны, так что немногим людям удается добиться в них вершин мастерства. Искусственному интеллекту дали поиграть в каждую из игр в течение недели, при этом жестко ограничив его возможности объемом памяти и быстродействием обычного современного домашнего компьютера. В качестве «подкрепления» при обучении при этом выступало количество набранных в игре очков.

В результате, в среднем Deep-Q-Network к концу недели набирал в каждой из игр на 20-30% больше очков, чем опытный игрок-человек. Иногда компьютерная система даже находила новые выигрышные стратегии, которые людям до сих пор придумать не удавалось.

Томас Подджио (Tomaso Poggio), директор Центра мозга, ума и машин Массачусетского технологического института (США), назвал это достижение впечатляющим: «Это означает, что компьютер, используя обучение с подкреплением, может научиться решать похожие реалистичные задачи, такие, как вождение машины». Однако при этом Подджио оговаривается, что даже вождение машины все же требует чего-то большего, чем просто умение набирать много очков в компьютерной игре.

По словам Хассабиса, следующая задача — научить систему переносить свой опыт из одной игры в другую, чтобы быстрее и эффективнее решать однотипные задачи.

Напомним, что для сейчас Google вовсю разрабатывает беспилотный автомобиль, для которого такой искусственный интеллект как раз может стать «водителем».