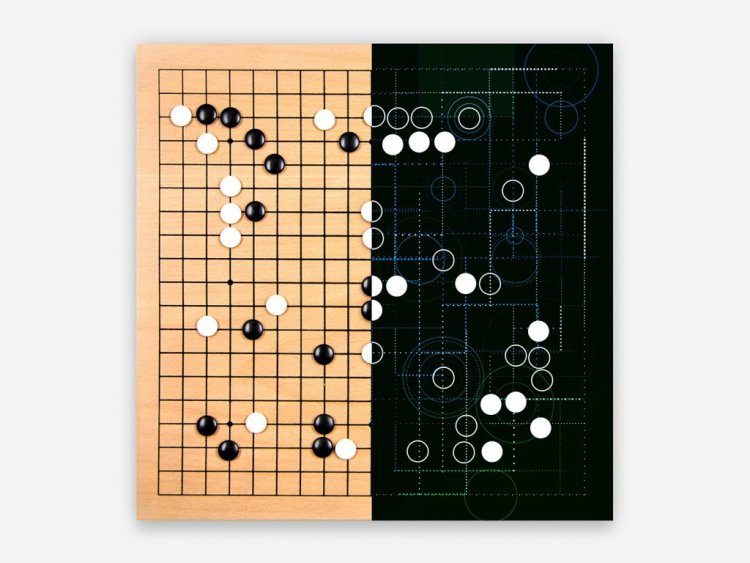

Программа AlphaGo, разработанная специалистами компании DeepMind (дочерняя компания Google), сумела одержать уверенную победу над профессиональным игроком в настольную игру го. Компьютер выиграл пять игр из пяти, сражаясь с чемпионом Европы по этой игре Фань Хуэем (Fan Hui), рассказывает сайт журнала Nature, в котором опубликована научная статья об этом достижении.

До этого состязания AlphaGo соревновалась с другими программами по игре в го и выиграла в 99,8% случаев. А в марте компьютеру предстоит сразиться с самым сильным в мире игроком в эту игру — корейцем Ли Седолем (Lee Sedol) — и разработчики алгоритмы уверены в победе своего детища.

В отличие от программы Deep Blue, обыгравшей Гарри Каспарова* (*Настоящий материал (информация) произведен, распространен и (или) направлен иностранным агентом Каспаров Гарри Кимович либо касается деятельности иностранного агента Каспаров Гарри Кимович) в шахматы в 1997 году, изначально алгоритм не учили играть и выигрывать в го. Искусственный интеллект самостоятельно обучался игре на примере реальных партий, обработав 30 миллионов комбинаций. Кроме того, параллельно применялся и метод перебора наилучших вариантов, которые обычно используют более слабые алгоритмы. По словам побежденного чемпиона, программа играла очень похоже на человека. «Если бы я не знал заранее, я бы мог подумать, что против меня играет реальный живой игрок, пусть немного странный, но очень сильный», — сказал Фань Хуэй.

Го — одна из древнейших настольных игр, она появилась в Китае около 2,5 тысяч лет назад. Ранее ученые подсчитали, что число допустимых комбинаций в игре превышает 10100 — это больше, чем атомов в наблюдаемой части Вселенной. Соответственно, считалось, что даже самый мощный компьютер не способен играть с профессиональным игроком-человеком на равных, поскольку перебрать все возможные варианты просто нереально.